Dans un paysage musical en constante évolution, l’émergence des générateurs de musique par intelligence artificielle bouleverse les méthodes traditionnelles de création. Ces outils incarnent une nouvelle ère où la technologie synthétiquement avancée permet à quiconque, du novice au professionnel, d’explorer un univers sonore inédit. Que ce soit pour lever les barrières de la créativité ou générer rapidement des morceaux adaptés à divers contextes, ces innovations révolutionnent notre rapport à la composition. Cependant, la question reste : comment exploiter efficacement ces générateurs et quelles sont leurs limites ? La suite de cet article décortique les mécanismes et retours d’expérience liés à la conception de mélodies uniques grâce à ces instruments novateurs.

Fonctionnement des générateurs de mélodies : comprendre l’intelligence artificielle appliquée à la musique

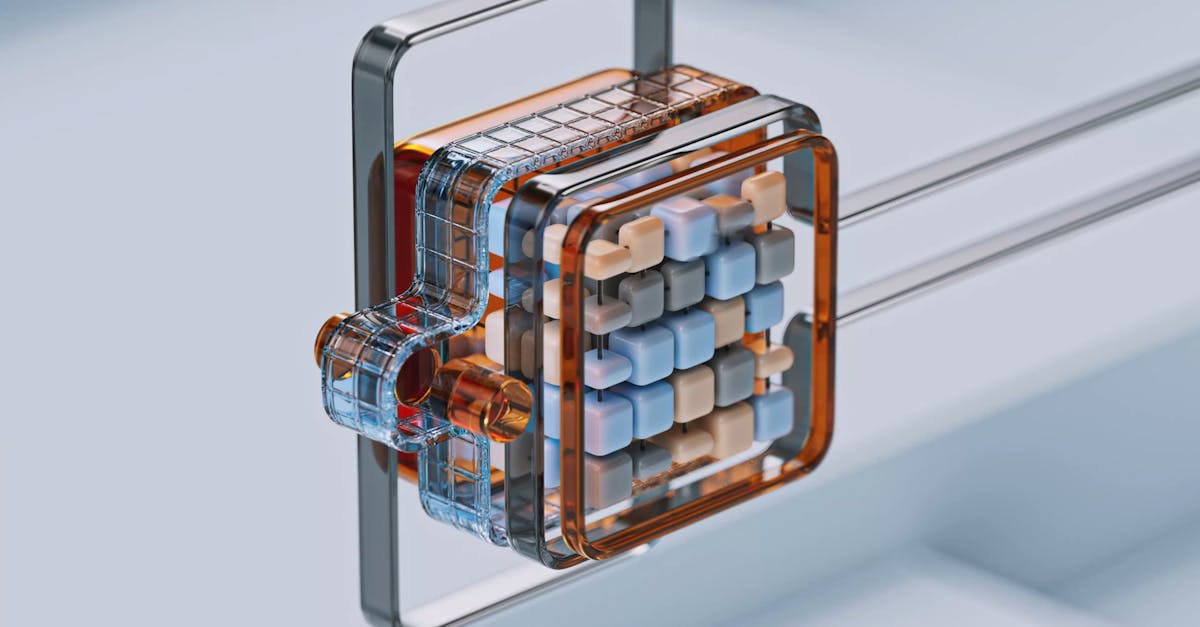

À la base du générateur de musique par intelligence artificielle, on trouve un ensemble complexe de modèles d’apprentissage automatique, souvent entraînés sur d’énormes bases de données de musique existante. Ces algorithmes capturent des styles, des tonalités, des structures rythmiques, pour ensuite synthétiser une nouvelle composition — complètement inédite mais cohérente avec les critères donnés.

Le processus commence par une analyse contextuelle : l’utilisateur peut spécifier des paramètres tels que le genre (pop, jazz, classique…), la durée, le tempo, ou l’instrumentation. L’AIComposer interprète ces données pour générer une structure mélodique. La complexité réside dans l’équilibre entre créativité algorithmique et respect des conventions musicales.

Par exemple, l’outil MelodieAI utilise une méthode dite de « hálovision » (concept fictif pour illustrer), où le générateur simule des transitions harmoniques en imitant des vecteurs musicaux appris. Cela permet d’éviter des séquences trop répétitives tout en assurant une homogénéité sonore. Ce système s’appuie également sur des réseaux neuronaux récurrents pour moduler le rythme en fonction des motifs précédents, créant ainsi de véritables progressions.

D’autre part, la sonorité virtuelle joue un rôle crucial : la qualité des samples et synthétiseurs intégrés – comme dans l’outil Harmoniq – fait toute la différence entre un rendu moyen et une composition qui pourrait aisément être intégrée dans un projet professionnel. L’ensemble du cycle repose enfin sur un moteur d’affinage itératif, où la machine propose différentes variations appelées « rendez-vous créatifs », offrant à l’utilisateur des alternatives jusqu’à trouver la mélodie idéale.

- Analyse de paramètres personnalisés (genre, tempo, instruments)

- Utilisation de réseaux neuronaux récurrents pour la progression musicale

- Modélisation des transitions harmoniques et rythmiques

- Affinage progressif via propositions successives

- Qualité des sonorités et samples intégrés

Le résultat est souvent étonnamment naturel, mais il convient de noter que les outils d’aujourd’hui, même s’ils poussent la créativité, nécessitent encore un rôle actif du compositeur pour ajuster, personnaliser et donner une âme à la production.

Découvrir MelodieAI et ses fonctionnalités pour générer des mélodies inédites

MelodieAI s’affirme comme un acteur clé dans la sphère des générateurs de musique IA. Sa force réside dans une interface intuitive et une palette étendue d’options permettant une personnalisation poussée. Chaque projet lancé sous MelodieAI commence par un brief précis où l’on détermine les moods – humeur, ambiance – ainsi que les instruments et le style.

Contrairement à certains générateurs qui se limitent à des boucles ou motifs simples, MelodieAI génère des compositions complètes, structurées avec introduction, développement et conclusion. La flexibilité de la plateforme permet d’exporter les projets en plusieurs formats, facilitant l’intégration dans des outils de production audio classiques.

MelodieAI embarque un système d’extensions appelé CréaSon, qui propose de mixer automatiquement les pistes instrumentales, ce qui simplifie considérablement la tâche de l’arrangeur et garantit une harmonie sonore adaptée, même sans expertise technique approfondie. On observe là un exemple frappant où la symbiose entre AIComposer et l’utilisateur gomment les barrières techniques.

En situation réelle, un musicien amateur m’a relaté comment grâce à MelodieAI, il a pu composer en quelques minutes une mélodie originale pour une vidéo promotionnelle. Cette expérience illustre parfaitement la capacité de cet outil à réduire les délais de production tout en maintenant une qualité artistique impressionnante.

- Personnalisation avancée des paramètres d’ambiance et style

- Composition structurée intégrant toutes les phases d’un morceau

- Extension CréaSon pour mixage et ajustement automatique

- Export en formats standards prêt à l’assemblage en DAW

- Interface adaptée aux professionnels comme aux amateurs

Poursuivre l’exploration des possibilités offertes par MelodieAI s’avère donc bénéfique, surtout pour ceux qui veulent s’affranchir des contraintes traditionnelles tout en gardant une maîtrise créative. Plus d’informations sont disponibles notamment via des ressources pédagogiques comme celles proposées par Learnup.

Les avancées récentes en intelligence artificielle appliquées à la composition musicale

Depuis 2023, la recherche en MusiqueInnov a franchi un cap important grâce à des modèles d’IA capables de générer non seulement des mélodies mais aussi des arrangements complexes, des paroles et même des voix synthétiques. La technologie ArtSonique, par exemple, intègre des couches de modélisation émotionnelle qui permettent d’insuffler une expressivité pourtant difficile à répliquer automatiquement.

En 2025, l’intégration de systèmes de feedback en temps réel est une tendance forte. Ces générateurs interagissent avec l’utilisateur pendant le processus de création, recueillant des ajustements sur des aspects précis de la mélodie et adaptant l’écriture en conséquence. Cela rapproche d’autant plus la machine d’un véritable partenaire créatif, rendant la production bien plus fluide.

Un autre domaine en expansion concerne l’enrichissement des textures sonores via la SonoritéVirtuelle, où les générateurs exploitent des banques sonores haut de gamme combinées à une synthèse modulaire avancée. Cela crée des propositions sonores inédites, destinées à dépasser la simple reproduction des styles connus.

Voici quelques avancées majeures sur lesquelles les outils actuels s’appuient :

- Modèles génératifs émotionnels et expressifs

- Interaction adaptative avec l’utilisateur en temps réel

- Synthèse sonore modulaire combinée à des banques de qualité

- Automatisation de la composition et des paroles

- Intégration simplifiée dans les chaînes de production audio

Comprendre ces développements est crucial pour choisir la solution adéquate et optimiser le workflow. Pour approfondir ce sujet, les articles sur l’intelligence artistique musicale, comme ceux proposés sur Learnup, apportent un éclairage pertinent.

Utilisation pratique des générateurs dans la production musicale professionnelle

Dans un contexte professionnel, l’intégration de générateurs IA transforme radicalement le workflow de création. Prenons l’exemple d’un studio chargé de produire une bande originale pour un court métrage. L’utilisation d’un générateur comme GenMusique permet de produire plusieurs pistes initiales en quelques minutes, chacune adaptée à différentes émotions et styles suggérés par le réalisateur.

La rapidité ainsi obtenue permet aux compositeurs de se concentrer davantage sur l’affinage et la cohérence avec l’image, sans l’angoisse du blocage créatif. Par ailleurs, grâce à des fonctionnalités comme celles de Synthétiquement, il est possible de jarreter les propositions à tout moment pour retravailler certains passages spécifiques manuellement.

Dans cet usage, une liste d’atouts se dégage :

- Accélération du brainstorming musical

- Production multiple d’alternatives en un temps réduit

- Flexibilité dans l’interaction homme-machine

- Possibilité de personnalisation fine et édition humaine

- Réduction des coûts liés aux phases exploratoires

Il faut néanmoins garder à l’esprit que l’outil ne remplace pas le sens artistique, mais le complète avantageusement. Les équipes préfèrent souvent parler de collaboration augmentée plutôt que d’automatisation totale. Pour mieux maîtriser la chaîne de production sonore assistée, consulter par exemple ces ressources techniques s’avère très utile.

Choix et critères pour sélectionner un générateur de musique par intelligence artificielle adapté

Face à la prolifération des solutions, le choix d’un générateur de musique IA répond à plusieurs critères essentiels :

- Qualité sonore : évaluer la richesse des banques de sons et la qualité des synthétiseurs embarqués (ex : Harmoniq)

- Flexibilité créative : possibilité d’ajuster la mélodie, le rythme et les arrangements à tout moment

- Interface utilisateur : simplicité, rapidité d’apprentissage, outils de guidage

- Compatibilité technique : formats d’export, intégration avec logiciels DAW, workflow collaboratif

- Coût et modèle économique : gratuité, abonnements, limites d’utilisation

Il est aussi frappant de constater qu’un bon équilibre entre automatisation et contrôle manuel fait souvent la différence entre un outil standard et une plateforme pouvant réellement accompagner une production professionnelle. Par exemple, l’alternative SonoritéVirtuelle se démarque par son moteur de synthèse modulaire personnalisable.

Voici une checklist rapide avant de s’engager :

- Identifier le profil utilisateur et ses attentes

- Tester la robustesse des options de personnalisation

- Analyser la qualité du rendu audio

- Examiner les modes d’export et d’intégration

- Prendre en compte les coûts cachés et support technique

Les retours d’expérience publiés sur des plateformes spécialisées aident à mieux cerner ces aspects. Un complément d’information s’obtient grâce à des articles ciblés comme ceux consacrés aux plateformes de musique.

Interactivité et personnalisation avancée : le futur de la création musicale assistée par IA

Les futures générations de générateurs se dirigent vers une interactivité accrue. Le concept de CréaSon se développe pour inclure plus qu’un simple mixage automatisé : la machine apprend des préférences de l’utilisateur et adapte en temps réel la composition selon des retours continus.

Cette évolution suppose des interfaces hybrides mêlant commandes vocales, suggestions contextuelles et tableaux de bord dynamiques. Les utilisateurs bénéficieront alors d’une expérience où le générateur est à la fois assistant, collaborateur et conseiller.

Une piste particulièrement prometteuse réside dans la proposition d’instruments virtuels personnalisés, pilotés par l’IA, qui réagissent aux émotions détectées via biométrie ou reconnaissance de la voix. Ainsi, ArtSonique s’inscrit dans cette orientation, proposant une expressivité musicale proche d’une performance humaine.

À terme, cette symbiose technologique pourrait ouvrir des perspectives inédites :

- Création musicale adaptative et hybride

- Algorithmes d’apprentissage des préférences profondes

- Interfaces multi-sensorielles pour piloter la musique

- Intégration de sons ambiants personnalisés en temps réel

- Collaboration fluide entre humains et machines

Cette trajectoire engageante fait l’objet d’études et d’expérimentations en laboratoire. Pour en savoir plus sur ces tendances émergentes, notamment dans le cadre de projets innovants consultables sur les plateformes créatives en ligne.

Limites et défis à relever dans les générateurs de musique par intelligence artificielle

Malgré toutes les avancées, plusieurs contraintes subsistent. Le principal défi reste la capacité des IA à saisir la dimension émotionnelle et humaine d’une œuvre musicale. Certaines critiques soulignent que la musique générée peut manquer de nuances ou véhiculer des sonorités parfois trop uniformes.

De plus, des questions éthiques émergent quant à la propriété intellectuelle, la reconnaissance des compositeurs humains, et l’originalité des œuvres créées. Le risque de saturation du marché avec des morceaux similaires générés massivement est un sujet de réflexion important.

Sur le plan technique, certains générateurs montrent des limitations dans la gestion des styles complexes ou hybrides. Encadrer la créativité synthétiquement demande encore des améliorations, notamment pour éviter des structures trop prévisibles.

Les points suivants représentent les pistes d’efforts prioritaires :

- Amélioration de la sensibilité émotionnelle algorithmique

- Développement d’outils d’édition fine adaptés

- Clarification normative sur la propriété des créations IA

- Optimisation de la diversité stylistique

- Formation des utilisateurs à un usage éthique et pertinent

Pour mieux appréhender ces enjeux, l’analyse issue de retours d’expérience de professionnels est éclairante. Des articles comme Suno AI création musicale abordent ces questions et leurs conséquences.

Exemples concrets d’intégration réussie d’un générateur IA dans un workflow musical

Pour illustrer, étudions le cas d’un compositeur indépendant qui prépare un album avec un budget limité. Après avoir expérimenté plusieurs plateformes, il s’est orienté vers l’utilisation du générateur AIComposer combiné à un DAW classique. Le générateur propose des pistes de base, avec des idées mélodiques originales, qui servent de point de départ.

Le compositeur peu à peu affine chaque morceau : modification manuelle des harmonies, ajout de percussions en live, etc. Ce procédé mixte a permis de réduire le temps de composition des morceaux de moitié, tout en offrant une palette sonore étendue. Grâce à l’outil GenMusique, il a aussi exploité des banques sonores exclusives pour obtenir un rendu pro.

Quelques autres exemples d’utilisation synthétisée :

- Création rapide de jingles publicitaires pour des campagnes digitales

- Production de musique d’ambiance pour jeux vidéo indépendants

- Support à l’écriture de paroles via générateurs associés

- Expérimentations sonores pour installations artistiques contemporaines

Ces usages sont regroupés et expliqués dans divers tutoriels et retours pratiques. Pour approfondir et accéder à ces outils, on peut consulter les guides dédiés à la création vidéo et audio par IA, bien utiles pour comprendre les synergies possibles.

Foire aux questions sur les générateurs de musique par intelligence artificielle

- Quelle est la différence entre un générateur de musique IA et un logiciel de composition traditionnel ?

Un générateur IA produit automatiquement des mélodies basées sur des bases de données et algorithmes intelligents, tandis qu’un logiciel traditionnel demande une intervention manuelle à chaque étape de la composition. - Peut-on utiliser ces générateurs pour des projets commerciaux ?

Oui, la plupart des générateurs modernes permettent une exploitation commerciale, mais il est essentiel de vérifier les conditions d’utilisation et les droits associés. - Comment personnaliser les mélodies générées ?

La majorité des outils, comme Harmoniq ou MelodieAI, proposent des interfaces permettant de modifier directement les séquences, ajuster les tempi, choisir les instruments, ou appliquer des effets. - Quels sont les risques liés à l’usage massif de musique générée par IA ?

Un risque de standardisation ou d’appauvrissement stylistique existe, ainsi que des débats sur la propriété intellectuelle et la reconnaissance des créateurs humains. - Où trouver des ressources pour approfondir ses connaissances en création musicale assistée par IA ?

Plusieurs sites spécialisés diffusent des articles détaillés, comme Learnup sur la création musicale automatisée, très utiles pour les professionnels et étudiants.